Ideja o korišćenju veštačke inteligencije za otkrivanje, a možda čak i cenzuru AI sadržaja na mreži, razvijala se tokom prošle godine. Međutim, ako je verovati nedavnim testovima, tačnost takve tehnologije je daleko od savršene – što znači da bi pravi sadržaj mogao biti lažno cenzurisan ako se takvoj tehnologiji veruje.

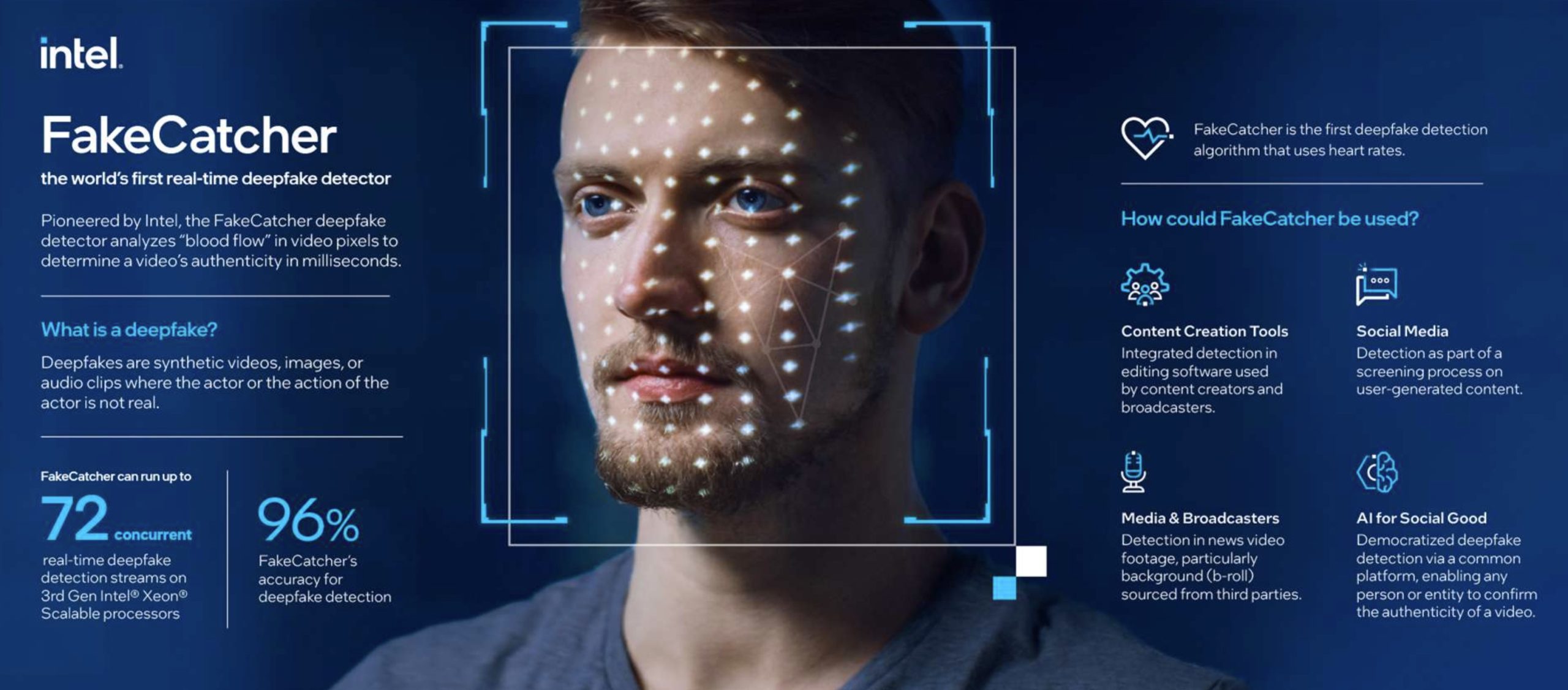

U borbi protiv deepfake video zapisa, Intel je objavio novi sistem pod nazivom „FakeCatcher“ koji navodno može da razlikuje originalne i prilagođene digitalne sadržaje. Efikasnost sistema je stavljena na test korišćenjem mešavine stvarnih i izmišljenih snimaka bivšeg predsednika Donalda Trampa i sadašnjeg predsednika Džoa Bajdena. Intel navodno koristi fiziološku osobinu fotopletizmografije, koja otkriva promene cirkulacije krvi i prati kretanje očiju da bi identifikovao i razotkrio ove lažne stvari.

Naučnik Ilke Demir, deo istraživačkog tima Intel Labs, objašnjava da proces uključuje određivanje autentičnosti sadržaja na osnovu ljudskih merila kao što su promene krvotoka osobe i konzistentnost pokreta očiju, preneo je Bi-Bi-Si.

Ove prirodne ljudske karakteristike se mogu otkriti u stvarnim video snimcima, ali ih nema u video snimcima napravljenim pomoću AI alata, objasnio je Demir.

Međutim, preliminarno testiranje je pokazalo da ova tehnologija možda nije sigurna. Uprkos hrabroj tvrdnji kompanije o 96% tačnosti za FakeCatcher, rezultati testa na sceni su kontrastna priča. Sistem je efikasno otkrio lažne snimke sinhronizovane sa usnama, ne uspevajući da prepozna samo jedan od nekoliko slučajeva. Zanimljivo je da se pravo iskušenje pojavilo kada su sistemu predstavljeni originalni video snimci, situacija u kojoj je neke stvarne video snimke pogrešno identifikovao kao neautentične.

Posle ukidanja računa Najdžela Faraža, JPMorgan Čejs banka gasi račune kompanijama dr Džozefa Merkolehttps://t.co/6RuYP16nMj

— Nulta Tačka (@NultaTackaSrb) July 27, 2023

Postoji uočljivo ograničenje sa pikselizovanim video zapisima ili video zapisima niskog kvaliteta, gde otkrivanje signala krvotoka lica postaje izazov. Štaviše, FakeCatcher-ova ne-audio analiza podrazumeva da se naizgled autentičan zvuk može označiti kao lažan.

Uprkos rezervi istraživača antidota kao što je Met Groh sa Univerziteta Northwestern koji je doveo u pitanje primenljivost prikazane statistike u stvarnim situacijama, Demir brani preoprezni pristup FakeCatcher-a koji ima za cilj minimiziranje propuštenih lažnih video snimaka.